Chers amis passionnés, dans la première partie consacrée à l’Intelligence Artificielle (IA), sujet traité en trois parties, nous avions vu ensemble l’introduction et l’historique de la chose. Pour lire ou relire tout cela, clique ici.

Dans la deuxième partie, nous avions vu les fondamentaux, les fonctionnements et les applications de l’IA. Pour lire ou relire tout cela, clique ici.

Maintenant, entrons dans le vif du sujet avec cette troisième et dernière partie !

Pour lire l’article en entier, ou pour n’en lire que certaines parties, clique sur ce qui te correspond dans le sommaire ci-dessous. Tu y arriveras immédiatement.

2) STATISTIQUES RÉCENTES DES USAGES DE L’IA

3) BON, EN CLAIR, QU’EST-CE QUE L’INTELLIGENCE ARTIFICIELLE ?

4) APPLICATIONS DE L’INTELLIGENCE ARTIFICIELLE (CERTAINES CROUSTILLANTES)

1) Deeper Blue, ordinateur d’IBM bat Garry Kasparov champion du monde d’échec

2) D’autres victoires d’ordinateurs

4) Reconnaissance de la parole, des visages, des empruntes, etc.

5) AMBIGUÏTÉ SUR L’EXPRESSION « INTELLIGENCE ARTIFICIELLE »

6) INTELLIGENCE ARTIFICIELLE FORTE

7) INTELLIGENCE ARTIFICIELLE GÉNÉRALE

8) QUESTIONS ÉTHIQUES (BENN OUI, QUAND MÊME)

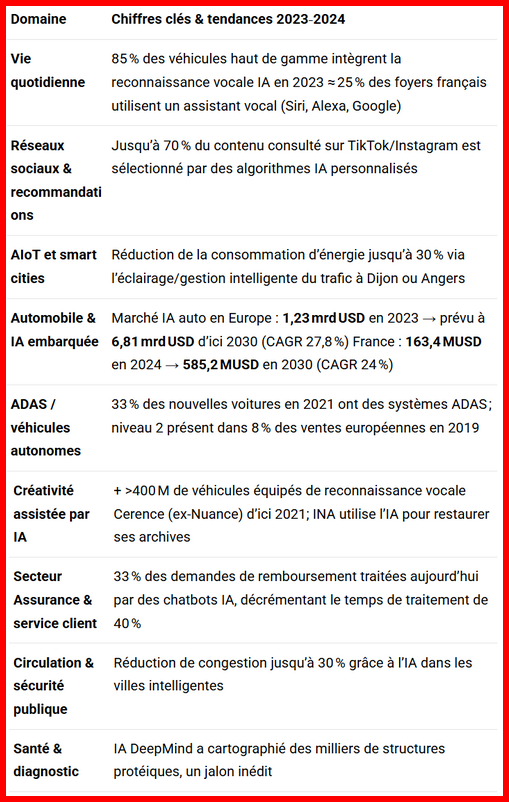

2) STATISTIQUES RÉCENTES DES USAGES DE L’IA

3) BON, EN CLAIR, QU’EST-CE QUE L’INTELLIGENCE ARTIFICIELLE ?![]()

Nous avons abordé cette question dans les deux premières parties. Cependant, une telle réponse comporte de nombreux éléments. Voici le dernier. Ça aidera ton petit pois…

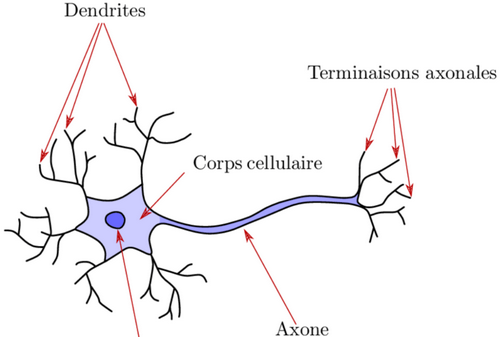

Le cerveau humain fonctionne grâce à des centaines de milliards de neurones qui ne cessent de communiquer entre eux. Cette communication est chimio-électrochimique et réalisée par les neurotransmetteurs (appelés aussi neuromédiateurs). Pour transmettre une information, un neurone émet un neuromédiateur (une molécule chimique) synthétisée (créée) par le cerveau. Le neurone voisin capte cette molécule, ce qui déclenche une impulsion électrique le long de sa terminaison nerveuse, l’axone. Il retransmet alors l’information en émettant à son tour un neurotransmetteur. Et ainsi de suite. C’est ce procédé que veut reproduire l’Intelligence Artificielle.

4) APPLICATIONS DE L’INTELLIGENCE ARTIFICIELLE (CERTAINES CROUSTILLANTES)![]()

1) Deeper Blue, ordinateur d’IBM bat Garry Kasparov champion du monde d’échec

La plus croustillante est celle de la défaite du champion du monde d’échec, Garry Kasparov, face à l’ordinateur d’IBM, Deep Blue en mai 1997. Qu’est-ce que Deep Blue ? Définition de Wikipédia qui me paraît bonne : « Deep Blue est un superordinateur spécialisé dans le jeu d’échecs par adjonction de circuits spécifiques, développé par IBM au début des années 1990. Il affronta une première fois en 1996 le champion du monde d’échecs de l’époque, Garry Kasparov, et perdit 2-4. Puis, surnommé alors Deeper Blue, il le bat 3,5–2,5 lors du match revanche en 1997, mais hors des conditions exigées lors des championnats du monde ».

La plus croustillante est celle de la défaite du champion du monde d’échec, Garry Kasparov, face à l’ordinateur d’IBM, Deep Blue en mai 1997. Qu’est-ce que Deep Blue ? Définition de Wikipédia qui me paraît bonne : « Deep Blue est un superordinateur spécialisé dans le jeu d’échecs par adjonction de circuits spécifiques, développé par IBM au début des années 1990. Il affronta une première fois en 1996 le champion du monde d’échecs de l’époque, Garry Kasparov, et perdit 2-4. Puis, surnommé alors Deeper Blue, il le bat 3,5–2,5 lors du match revanche en 1997, mais hors des conditions exigées lors des championnats du monde ».

Pour le plaisir, quand tu achètes ton ordinateur pour écrire tes lettres d’amour à ta dulcinée, dans le meilleur des cas, celui-ci possède 4, aller, voir 6 cœurs. Deep Blue en possédait 32, et 480 circuits, en 1997. Il était capable d’évaluer 200 millions de positions par seconde par des algorithmes utilisés en intelligence artificielle. Malgré sa puissance, il était classé 259ème dans la liste TOP 500 des superordinateurs les plus puissants en juin 1997.

Pour le plaisir, quand tu achètes ton ordinateur pour écrire tes lettres d’amour à ta dulcinée, dans le meilleur des cas, celui-ci possède 4, aller, voir 6 cœurs. Deep Blue en possédait 32, et 480 circuits, en 1997. Il était capable d’évaluer 200 millions de positions par seconde par des algorithmes utilisés en intelligence artificielle. Malgré sa puissance, il était classé 259ème dans la liste TOP 500 des superordinateurs les plus puissants en juin 1997.

Bon, aller, on va se consoler. Le 11 mai 2012, qui marquait l’anniversaire des 15 ans de la victoire aux échecs de Deep Blue, le supercalculateur d’IBM, contre le Russe Garry Kasparov, l’un des concepteurs de la machine, cité dans un ouvrage (« The Signal and the Noise » (Le signal et le bruit) rédigé par Nate Silver), explique que la supposée stratégie de jeu ayant déstabilisé le grand champion était un bug informatique !

L’auteur de l’ouvrage a en effet interrogé Murray Campbell, l’un des trois principaux concepteurs de Deep Blue. Selon lui, ce fameux coup proviendrait en réalité d’un bug… Alors qu’elle était programmée pour résoudre jusqu’à 200 millions de positions par seconde, la machine s’est avérée incapable d’en choisir une. C’est donc de façon totalement aléatoire qu’elle a déplacé un pion, engendrant son sacrifice.

En effet, Deep Blue se limitait à répondre au coup par coup. Par ce sacrifice du pion (totalement aléatoire) l’ordinateur a donné au champion, avec cette manœuvre imprévisible, l’impression qu’il mettait en place un jeu stratégique de longue haleine. Ayant alors une toute autre perception de Deep Blue, Kasparov a totalement changé de stratégie.

Puis, face à ce jeu contre-intuitif, cherchant le piège, le champion a pensé que Deep Blue possédait une intelligence supérieure, ce qui a eu pour effet de le déstabiliser jusqu’au bout de la rencontre, qu’il a perdue (1 victoire, 3 nulles, 2 défaites).

Au final, le supercalculateur n’avait pas imaginé un coup de maître, mais a simplement eu de la chance face à un adversaire déstabilisé.

Passionnant, non ?

https://www.youtube.com/watch?v=jpCa9D2KPXM

1997 : l’ordinateur bat Garry Kasparov, un tournant dans l’histoire des échecs | INA

2) D’autres victoires d’ordinateurs![]()

D’autres machines l’ont emporté sur l’un des meilleurs joueurs de go au monde – le Sud-Coréen Lee Sedol (2016) – et sur d’excellents joueurs de poker (2017).

Des ordinateurs démontrent ou aident à démontrer des théorèmes mathématiques et construisent automatiquement des connaissances à partir de masses immenses de données (big data) dont le volume se compte en téraoctets (1012 octets), voire en pétaoctets (1015 octets), avec des techniques dites d’apprentissage machine.

4) Reconnaissance de la parole, des visages, des empruntes, etc.

Des automates reconnaissent la parole articulée et la transcrivent, comme les secrétaires dactylographes d’antan, et d’autres identifient avec précision des visages ou des empreintes digitales parmi des dizaines de millions et comprennent des textes écrits en langage naturel. Toujours grâce à ces techniques d’apprentissage machine, des voitures se conduisent seules, des machines diagnostiquent parfois mieux que des dermatologues des mélanomes à partir de photographies de grains de beauté prises par des téléphones portables, des robots font la guerre à la place des hommes et les chaînes de fabrication automatisées se multiplient dans les usines.

Ces applications de l’intelligence artificielle affectent presque tous les domaines d’activités, en particulier les secteurs de l’industrie, de la banque, des assurances, de la santé, de la défense, car de nombreuses tâches routinières sont désormais susceptibles d’être automatisées, ce qui transforme bien des métiers et en supprime certains.

5) AMBIGUÏTÉ SUR L’EXPRESSION « INTELLIGENCE ARTIFICIELLE »![]()

Le succès de l’expression « intelligence artificielle » repose parfois sur un malentendu lorsqu’elle désigne une entité artificielle douée d’intelligence et qui, de ce fait, rivaliserait avec les êtres humains.

Cette idée d’une intelligence artificielle venant à dépasser à terme l’ensemble des facultés humaines renvoie à des mythes et des légendes anciennes telle celle du Golem (être, le plus souvent de forme humaine, créé par un acte de magie grâce à la connaissance des dénominations sacrées), réactivée pourrait-on dire depuis le milieu des années 2010 par des personnalités comme l’astrophysicien Stephen Hawking (1942-2018), Elon Musk, l’ingénieur Ray Kurzweil ou encore par les tenants de ce que l’on appelle aujourd’hui l’« intelligence artificielle forte » et l’« intelligence artificielle générale ».

À noter, quand même ami passionné, que certains, comme Elon Musk, se posent des questions d’éthiques, alors que d’autres (comme Ray Kurzweil) s’en réjouissent. Cela étant, tous supposent que l’intelligence artificielle excédera la nature humaine, au point de mettre en cause sa suprématie. Nos descendants verront bien…

6) INTELLIGENCE ARTIFICIELLE FORTE![]()

La notion d’intelligence artificielle forte a été introduite en 1985 par le philosophe américain John Searle qui souhaitait distinguer l’intelligence artificielle des informaticiens, qu’il nommait « intelligence artificielle faible », de celle dont rêvaient certains de ses collègues philosophes d’orientation cognitiviste et qui aurait été, selon eux, en mesure d’accéder à la signification et à la compréhension, qu’ils nommaient « intelligence artificielle forte ».

Or, selon John Rogers SEARLE, philosophe américain, 92 ans, spécialiste de la philosophie du langage et de l’esprit (bon…) l’intelligence artificielle des informaticiens ne procède qu’à des manipulations syntaxiques sur des symboles, ce qui ne lui permet pas d’accéder à leur sémantique, autrement dit au sens. De même, contrairement à ce que prétendaient certains philosophes cognitivistes, pour John Searle, l’intelligence artificielle n’accède ni à la conscience ni à l’émotion.

Pourtant, à la fin des années 1980, des roboticiens, dont Hans Moravec, ont prétendu renouveler l’intelligence artificielle en lui permettant de simuler la perception des objets, d’accéder au sens et par là d’ouvrir la voie à la réalisation d’une intelligence artificielle forte.

Les succès de l’apprentissage profond depuis le milieu des années 2010 donnent une vigueur renouvelée aux partisans de l’intelligence artificielle forte. Néanmoins, il n’existe ni preuve scientifique, ni démonstration expérimentale laissant entendre qu’elle soit réalisable et a fortiori à notre portée.

7) INTELLIGENCE ARTIFICIELLE GÉNÉRALE![]()

Tout évoluant sans cesse comme tu le sais, ami patriote, depuis la fin des années 1990, certains chercheurs prétendent que l’on peut accéder aux principes généraux de l’intelligence et les programmer sur une machine.

Ce courant appelé « intelligence artificielle générale », expression introduite en 1997, cherche à dégager un principe ultime qui serait au fondement de n’importe quelle intelligence. Rien que ça.

Ses tenants sont généralement des physiciens qui essaient de trouver une formalisation mathématique générique résumant toutes les facettes de l’intelligence, qu’il s’agisse de l’intelligence humaine ou animale ou encore génétique, voire physique.

Autrement dit, ils aspirent à trouver une formule mathématique qui rendrait compte de l’ensemble des formes d’intelligence qui existent dans la nature. Si une telle formule existait et si l’on pouvait concevoir une machine qui soit en mesure de l’exploiter, nous pourrions éventuellement réaliser une intelligence artificielle forte, consciente d’elle-même, ou réduite à un phénomène abstrait, calculatoire, dénué de sensibilité et d’affect, mais qui, dans tous les cas, nous dépasserait. Ouf, vaste programme, collègue passionné, n’est-il pas ?

Mais rassure-toi, ami. Dors sur tes deux oreilles si tu y arrives, ton serviteur n’y ayant jamais parvenu. Il n’existe actuellement aucun élément empirique validant l’approche de l’intelligence artificielle générale, qu’il faut bien qualifier de purement spéculative.

Ajoutons enfin que, depuis les années 1980, les sciences cognitives montrent que l’intelligence est la résultante de facultés mentales différenciées selon les individus et ancrées dans nos cerveaux, et qu’en conséquence, elle n’est rien moins que générale.

8) QUESTIONS ÉTHIQUES (BENN OUI, QUAND MÊME)![]()

Avec l’intelligence artificielle, la plupart des dimensions de l’intelligence – sauf peut-être l’humour – font l’objet d’analyses et de reconstructions rationnelles avec des ordinateurs. De plus, les machines outrepassent les facultés cognitives de l’homme dans la plupart des domaines, ce qui fait craindre à certains des risques d’ordre éthique.

On a fait beaucoup de commentaires sur la question des voitures autonomes. L’expérience de pensée selon laquelle les ingénieurs qui programment une voiture devraient froidement choisir entre l’option :

– écraser cinq jeunes gens insouciants traversant la rue au feu vert

ou

– celle de sacrifier la vie du passager du véhicule

Ceci a beaucoup marqué l’opinion.

L’accident de Tempe en Arizona – à ne pas confondre avec Trump 😊 – en mars 2018, mettant en jeu une voiture autonome de la société Uber montre pourtant que les enjeux sont assez différents selon les concepteurs.

Pour le confort des passagers, Uber avait décidé que la voiture ne prendrait pas en considération les obstacles inattendus, comme les sacs en plastique ou les feuilles mortes, qui rendent la conduite lente et chaotique.

Cette nuit-là, le piéton qui traversait la rue en poussant son vélo sans signalisation a donc été volontairement ignoré par le logiciel de conduite, bien qu’il ait été détecté par les capteurs du véhicule. Sa mort, qui n’est pas liée à une défaillance du système mais à un réglage trop tolérant, ne permettant pas à la voiture de réagir en temps voulu, est venue renforcer les interrogations quant à la sécurité des voitures autonomes.![]()

Plus généralement, les risques éthiques sont de trois ordres :

a) une raréfaction du travail, remplacé par l’activité des machines

Cependant, un examen détaillé démontrerait que l’automatisation de certaines tâches n’entraînerait pas nécessairement la disparition du travail humain. Les études parues sur ce sujet concluent de façon divergente : certaines prophétisent l’automatisation de tous les métiers avant le milieu du XXème siècle, mais la méthodologie qu’elles suivent laisse les scientifiques dubitatifs. D’autres expliquent que le travail se transforme et fait appel à de nouvelles compétences, de sorte qu’il en va identiquement avec le développement des technologies d’intelligence artificielle qu’il en est allé dans le passé avec d’autres technologies : certains métiers ont disparu, d’autres ont évolué et quelques-uns sont apparus.

b) des conséquences pour l’autonomie de l’individu, en particulier pour sa liberté et sa sécurité.

Concernant l’autonomie de l’individu et sa liberté, selon certaines études, elles ne sont pas inéluctablement remises en cause par le développement de l’intelligence artificielle, à condition toutefois de demeurer très vigilant face aux intrusions de la technologie dans la vie privée, notamment via l’exploitation des données personnelles collectées.

Ton serviteur reste extrêmement sceptique, pour ne pas dire convaincu, que toutes ces collectes d’identifications des individus, déjà exploitées pour la surveillance de la moitié de la planète, le seront bientôt en Europe, où elles sont déjà existantes en partie.

c) un dépassement de l’humanité, laquelle disparaîtrait au profit de machines plus « intelligentes ».

Des études, toujours elles (!) et contrairement à ce que certains prétendent, les machines ne constitueraient aucunement un risque existentiel pour l’humanité, car leur autonomie n’est que d’ordre technique, en cela qu’elle ne correspond qu’à des chaînes de causalités matérielles qui vont de la prise d’information à la décision.

En effet, les machines n’ont pas d’autonomie morale car, même s’il arrive qu’elles nous trompent, par les textes et les images qu’elles génèrent, ou qu’elles nous déroutent et nous fourvoient dans le temps de l’action, autrement dit qu’elles nous dressent des pièges, ceux-ci ne sont jamais intentionnels car elles n’ont pas de volonté propre et restent asservies aux objectifs que nous leur avons fixés.![]()

Pourquoi pas ?

Et bien voilà, cher ami passionné, je te laisse ingurgiter les trois volets de ce sujet qu’est l’Intelligence Artificielle.

Bonne dégustation, comme on dit dans les restos chics. Si le serveur te dit « Bon appétit » ou rien, c’est que le resto n’est pas classe. Dans ce cas-là, pour toi, l’addition sera moins lourde…..en principe !

À la prochaine

Bye bye !

511 total views, 1 views today

Je n’avais pas relu, et mon 3e paragraphe est obscur; donc je dois préciser: »Pour la question des dangers possibles engendrées par le hasard ou par des questions qu’on pose à la machine lui demandant des prouesses ou des éclairs de génie etc » c-à-dire ce que l’humain est capable d,innover grace au concours pas de la raison seule, mais de la coopération entre raison, imagination, affects

Merci Lylie de l’intérêt que tu portes à mes modestes articles. J’ai bien lu tes deux derniers posts.

La notion de sentiment, imagination, mémoire individuelle, émotion, jugement individuel, pour faire simple d’orientation cognitiviste d’un ordinateur, constitue la notion d’Intelligence Forte, terme inventé par John Searle en 1985.

Certains souhaiteraient que les ordinateurs aboutissent à de telles capacités, ce qui les rendraient égaux aux humains.

Comme le dit Rogers SEARLE l’intelligence artificielle des informaticiens ne procède qu’à des manipulations syntaxiques sur des symboles, ce qui ne lui permet pas d’accéder à leur sémantique, autrement dit au sens. De même, contrairement à ce que prétendaient certains philosophes cognitivistes, pour John Searle, l’intelligence artificielle n’accède ni à la conscience ni à l’émotion.

Voir le paragraphe de l’article intitulé : « 6) INTELLIGENCE ARTIFICIELLE FORTE ».

Tout cela, pour le moment…

je suis nulle en informatique (mais j,ai quelques connaissances moyennes en biologie, physiologie et une passion pour le phénomène mémoire avec, chez l’humain, ses transformations par le temps etc).

Cette question d’IA m’intérroge bcp. Alors: le bug en question montre que le hasard peut intervenir; de plus, en dépit des quantités de données, est-ce que la machine est capable des prouesses de l’imagination, c-à d: créer une ou des données encore jamais trouvée(s)dans l’histoire humaine; ce qu’on appelle les éclairs de génie/ou des créations de voies neuronales inédites, ou un phénomène d’évolution ? ou ??

La question de dangers possibles venus soit du hasard, soit de situations nouvelles créées par le sentiment ou l’imagination ou une mémoire individuelle ou.. plus que par la raison ne se pose-t-elle pas? Imprévus qui donneraient par exemple occasion à la machine de surpasser l’humain en bien ou en mal?? Je divague peut-être.

Merci pour ce beau dossier en 3 parties. Ce dernier article propose une excellente synthèse des différents aspects de l’intelligence artificielle, en allant du fonctionnement de base inspiré du cerveau humain jusqu’aux applications concrètes qui bouleversent déjà plusieurs secteurs. La distinction claire entre IA faible, forte et générale permet de mieux comprendre jusqu’où nous en sommes réellement aujourd’hui, mais aussi les défis théoriques et éthiques qui restent à relever.

Parfaitement bien résumé…..

En fait, l’IA est déjà très utilisée, dans beaucoup de domaines. Les gens la découvrent par l’émergence des GPT, mais ce n’est qu’une application supplémentaire

Bonjour,

Merci Cachou pour cette belle série !

Je ne sais pas si tu as lu, sur ce sujet de l’IA, le roman « Maniac » : il traite des personnalités de Paul Ehrenfest, de John Von Neumann et se termine par les exploits d’Alpha Go aux championnats du Monde de Go …

C’est très intelligemment écrit …

Non, je n’ai pas lu ce roman « Maniac » de Benjamín Labatut. Mais je viens d’en lire un long résumé qui met l’eau à la bouche, et drôlement !

J’essayerai de trouver le temps de le lire. Merci, ami.

****************

https://laregledujeu.org/2024/09/24/40930/maniac-une-genese-romanesque-de-lintelligence-artificielle/

Cher professeur, une remarque à propos de l’intelligence humaine : quand on voit à quoi certains humains occupent leur intelligence, on est en droit de se poser la question de savoir s’il ne vaudrait mieux pas les remplacer par de l’IA. Ainsi à l’Élysée, au Sénat, à l’AN, etc.

Tu es un grand chanceux, ami Argo, d’avoir trouver de l’intelligence dans ce beau pays musulman qu’est Islamofrance.

Pour ma part, après 40 ans de fouilles minutieuses au pinceau, je n’en ai toujours pas trouvée.

Bonjour ami Cachou. C’était ironique. Einstein a dit : L’intelligence artificielle ne fait pas le poids face à la stupidité naturelle. C’est évident que la stupidité de la majeure partie de nos compatriotes nous a amenés là où nous sommes. Cela fait bientôt quarante ans et même un peu plus que je râle contre l’invasion continue et organisée de notre pays. Qu’est-ce que j’ai pris durant ces années. J’ai eu l’impression de parler à des murs. Le présent a fini par me donner raison. Hélas.

MDR ami Argo !!

Et, comme d’habitude comme observateur attentif du Monde, tu ne dis que des vérités….

Merci Cachou pour ce troisième volet qui aborde la question la plus intéressante :l’éthique. Sans vouloir te contrarier, j’ai noté quelques coquilles :

-chimio-électrochimique, ne devrions pas dire plutôt :électochimique ou chimio-électrique?

-les études prophétisent l’automatisation de tous les métiers au milieu du XXème siècle: ne faut il pas lire XXIème siècle ?

Merci encore et bonne journée.

Tu as entièrement raison, ami Le chti français, il s’agit là de deux coquilles.

Le terme de chimio-électrochimique est, en fait, un pléonasme. S’il est « chimio », c’est qu’il est « chimique ».

Quant à la deuxième coquille, c’est parce que je ne me suis certainement pas encore fait qu’on a changé de siècle.

L’âge, 72 ans, probablement. Bon pour la retraite ?? 🤣😂

La retraite à 72 ans? Tu n’y pense pas ,tu es bien trop jeune! En voulant te faire part de tes coquilles, je viens de m’apercevoir que j’ai fait une boulette: le R du mot électrochimique est absent suite à la lenteur de l’IA intégrée à ma cochonnerie de materiel made in PRC ou china si tu préfère 🤣🤣🤣. Bonne soirée !

😊